抛砖引玉,谈一点现在的AI技术和芯片的事情(更新)

- veblen上一次看到那个阿里的AI芯片的贴子,一些基本的名词还有不少人不清楚,所以简要来介绍一下。其实AI的核心技术还是机器学习,从计算机发明之初就开始的研究。但为什么突然间变火了呢?主要是硬件技术累积到一定程序,外加算法也有了一些突破性的进展,主要深度学习相关的算法,并且成功应用于多个领域。

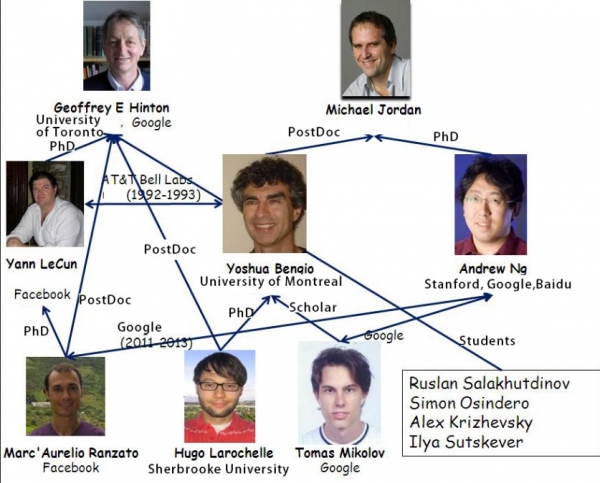

这一波深度学习发源其实不在美国,而是加拿大。主要领军人物应该被戏称为“加拿大黑手党”的三位大牛:Geoffrey Hinton, 他曾经的博士后,Yann Lecun,以及与Lecun合作密切的Yoshua Bengio。 Lecun后来去美国来到纽约大学。

(现在这些大牛肯定已经各家巨头瓜分了,那Bengio其实在微软也是挂职,微软为了他还特地在蒙特利尔搞个研发中心)

深度学习主要的工具是神经网络,对,就是想来模仿你的大脑里面的神经网络。什么神经元,激活等概念用计算机其实很比较好模仿,Hinton毕业的七十年代正好赶上这一波,于是一入侯门深似海,干了近四十年才出头。主要难点在于如何学习,特别在那个计算能力十分有限的年代。很快神经网络技术就被质疑,很多人都转行了。但是Hinton坚持下来了,在2004还等来加拿大一年50万美元的经费,再和其它专业的大拿合作后,逐步完善了相关的算法(细节不写了,想了解拿Hinto名字作为关键字搜索吧)。在Hinto苦心研究的上个世纪,Lecun和Bengio也分别在图像处理,和自然语言处理等领域上应用和改进了神经网络算法,为日后的爆发打下坚实的基础,也奠定各自的江湖地位。

时间来到2009年,微软邀请Hinton在一个小型的技术分享会介绍一下深度学习的研究成果。会后邓立和俞栋两人将相关成果应用于语音识别上,取得近25%的识别错误率的下降,类似于累积五年以上的语音识别研究成果所能取得进展,震惊了学术圈。今天你可以愉快喊小爱,或者SIRI,就应该归功于这个发现——即如果给予深度学习足够多的数据和计算资源,后者有可能从事更加复杂的AI技术。而计算机的硬件发展和云计算正好提供了这样的机会。果然,2012神经网络是图像任务的AlexNet模型以高出第二名十几个百分点的差距吊打所有其他ImageNet参与者。成功引爆整个产业界,从此AI变成一个热词,变得无人不知。

那么AI的发展跟芯片又有什么关系呢?其原因就在于深度学习需要大量的计算资源,很多模型一般的计算机根本扛不住,大公司有钱能够提供足够多的CPU来进行计算。但如果需要整个产业的发展,这么烧钱肯定没法玩下去。其实,硬件这方面都早了做了准备,Nvida在2007就推出的CUDA技术终于找到最大用武之地(又是一个能熬的典型)。几百甚至上千上万个并发内核一起计算,从而让更多的公司和个人参与了这个技术浪潮中来。

CUDA为什么就能快了呢?打个比方,一个人需要驾车穿过未知区域,可能有急弯或大的坡度什么的,为了安全,车速就被限定的比较低。而且要求驾驶员有经验,技术好。但如果是一个已和比较平坦的区域,那么驾驶员不用技术好,也可以直接飙车了。这里前者就像通用芯片如X86的研发,能够适应各种应用场景,但速度不快,并且技术研发复杂(需要车技好)。但深度学习的芯片则是后者,因为深度学习的计算非常雷同,就是各种矩阵的乘法,说到底就是大量加乘运算,所以研发这样芯片不复杂,芯片本身也不复杂,可以靠猛堆计算核心来提供更高的计算性能。

D板的聪明人可能马上看出来了,技术不复杂,那为啥中国不搞呢?答案是当然中国也在搞。CUDA及其后续技术因为研发时间早,生态圈非常成熟,现在还是一枝独秀。但是这个市场前景太广阔了,又不像X86那样有专利壁垒,各个巨头自然不会放过,如GOOGLE TPU,APPLE的IPHONE里面NPU等。回到国内,做这方面有名的寒武纪科技,估值都已经超过一百多亿了,还有D板上次讨论的阿里芯片。在现在阶段,相关技术还有快速发展,标准很难统一,所以不管公司大小,都有机会来公平竞争。同样,没权威标准,各家之间的芯片性能比较就难以客观,靠你自己解读了。

Unabashedly ask, If you are a github user, would you please stargaze one of my team projects,https://github.com/onnx/keras-onnx? - logic90实际上,ai的加速芯片和传统的cpu完全不同。。。

ai加速芯片,用的是asic,难度比通用cpu低了一个数量级。。。asic芯片中国搞得还是挺好的,比特大陆就是自己研发的asic芯片

至于ai的相关理论研究,已经很久没有开创性的理论突破了。。。目前主要靠的还是堆算力,还有各种模型结构的创新。。。应用上的创新潜力很大

综上,目前中国这边确实有可能在ai领域实现弯道超车,毕竟大家都是同一起跑线上竞争的HiPDA·NG - jckimi

- davie现在的ai技术是基于统计的?

- logic90现在主流都是搞神经网络了。。。端到端的训练神经网络,不太在意内部的细节

至于搞出来的模型是个什么东西,不太好解释。。。一般把这个过程称作炼丹,模型炼出来之前基本上不知道出来的会是什么东西

所以说,这东西现在搞的没什么门槛。。。大牛也解释不清楚细节,大牛也没法形成确定的理论,大家都是一股脑的炼丹玩HiPDA·NG - davie这个解释牛逼 炼丹 练出来啥是啥

- svbiz感兴趣的可以看一下《深度学习入门 基于python的理论与实现》,数学只有高中水平的话再给合《深度学习的数学》,能大概了解到深入学习的原理。

- jqustc楼主业内人士?爱之语

- loveless21谷歌下一代手机也搭载最新研发的Pixel Neural Core芯片了

- singlejoe在研究卷积神经网络用于图像处理

- rock32谢谢科普 iOS fly ~

- 77880099

- wen谢谢科普 iOS fly ~

- 马二甲谢谢楼主,以clip保存

这年头论坛mark不靠谱,收藏的帖子都成历史遗迹了 - zybest手机上的ai芯片是干嘛用的,又不需要做training,只要用PC上训练好的模型还要靠硬件加速?

- 猫了个咪的

- 猫了个咪的其实学术界早都质疑这种黑暗的炼丹模式或者说黑箱模式了。世界各国都在有人研究如何从数学上解释深度学习,以及用知识指导ai工作。国内清华成立的人工智能研究中心就在做类似工作,感兴趣的可以查查新闻

- hooan学习了,做个几号

- rochester回复15#zybest

必须的呀! iOS fly ~ - nglee回复1#veblen

感谢lz开贴和logic90的回复,刚好假期看了一些相关的内容,并且今天也刚好因为之前做ASIC的经历被一家AI芯片公司联系。

说说我的一点点看法。

首先lz谈到的,AI芯片可能是国内超车的机会,这点表示认同,ASIC本身就相对于通用CPU门槛比较低,加上大家起步没有太大的差别,制造工艺也类似,比通用CPU的竞争格局要有利的多。

其次是互联网公司手握的海量数据以及巨大的需求也是一个客观存在的资源和市场,云计算公司手握了大量数据,本身挖掘数据的价值就是个头疼的问题,现在再好不过了,训练DNN依赖的海量数据,加上zf的大力鼓励,推动了互联网公司加大投入。

但是AI的ASIC对于小型创业企业来说还有机会么?我认为是有可能的,首先是安防这一块儿是个巨大的2B市场,肯定不只是会让huawei一家独大;

其次是,以SNN这类另辟蹊径的,只需要少量数据,可以实现极低功耗的模式,会在边缘计算方向有着极大的优势,大量嵌入式的可穿戴设备都可以配备,有可能会出现dialog那种14580在蓝牙芯片领域异军突起的势头。

暂时想到这些,稍后再更。。。。 - hook此贴甚好,期待牛人们继续盖楼… iOS fly ~

- hookgao有没两本书的下载链接啊 iOS fly ~

- qiuike什么时候人类的AI可以达到蟑螂,蚂蚁,乌鸦的智力?

- hitmanx每个人的侧重点看来都不一样,正好互补。我因为工作原因相对比较熟悉cuda以及gpu底层架构以及性能分析这一块,但是对于上层的应用场景如深度学习不太了解。有机会多交流 iOS fly ~

- apex100学术界也有种观点认为,现在应用普遍的深度学习技术走的还是大数据、浅智能的路子,智力水平尚不及蚂蚁乌鸦这些小动物,未来真正有潜力的AI应该是小数据、强智能的方向,即通过少量的场景学习就能实现逻辑推理和泛化应用的能力

- everchens漏了GANs之父Ian Goodfellow

- skke收藏,最近在看这方面,填鸭式听课,下来自己慢慢在Coursera上学,发觉数学可能是我需要先补上的

- 土豪金学习了,公司老板也喊着上ai,初步看了下投入巨大而且效果没谱

- veblen如果你说是通用智能,AGI,提这个基本都大忽悠。我没有看到有实际意义的算法或论文。但是单项任务上,别说阿猫阿狗,很多方面已经把人比下去了。

有名的Deepmind的Alpha Go,下棋机器比人牛。

还是像在ImageNet做图片分类的,机器准确率已经超人类。

音箱的语音可懂度早超过一般人,接近播音员。

等等。

总之,有明确规则的事情,机器已经或将要超过人类。 - veblen个人一点看法,如果着眼长远或者就想做AI的生意,可以入。如果想用AI给现有的业务赋能,还得三思啊!太烧钱了,人才贵,硬件也不便宜。

- veblen专用芯片其实解决不光是复杂度的问题,更关键的是能耗比的,即给定的运算量(FLOPS),完成运算所需要的能量。IPHONE 从10开始,把感应器的数据处理放到NPU上,比较人脸识别和自动亮屏等,放到主芯片当可以,但是费电啊。

- qiuike

- davidchiu先马克一下

- nglee

- TomYao人工智能60年。

人工智能60年发展历史.pdf(5.33 MB)

人工智能60年发展历史.pdf(5.33 MB)

普通上传后无文件名,批量上传正常。 - stefwooGAN好玩,需要的数据量也小得多 iOS fly ~